Resume

Обратная связь:

почта - it38dato@yandex.ru, телеграмм - @it38dato.

Show more

Обо мне

Инженер-программист, г. Иркутск. Я специалист в области информационных технологий с более 5 лет опыта в администрировании баз данных, локальных, виртуальных и облачных серверов и в разработке программного обеспечения. Для саморазвития я в свободное время читаю и перевожу техническую документацию на английском языке, администрирую свой веб-сервер http://dato138it.ru, дорабатываю свои проекты https://github.com/it38dato и решаю задачи на фрилансе. Мне интересно работать в команде, активно развиваться в программировании и администрировании, изучать новые технологии.

Навыки:

Html, Css, Js, Спутниковые радионавигационные системы, С++, Виртуализация, Linux, Bash, Windows, Python, English, Sql, Clouds, Docker, Ericsson, Nokia, Vba.

Услуги:

# Верстка Веб-страниц.

# Разработка Парсинг данных.

# Анализ сетевых технологий.

# Администрирование локальных серверов.

# Администрирование виртуальных серверов.

# Администрирование локальных сетей.

# Администрирование Веб-серверов.

# Разработка Автоматизация установки и настройки ПО.

# Разработка Восстановление флешки.

# Написание Sql запросов.

# Администрирование баз данных.

# Разработка баз данных.

# Разработка Бэкап.

2018-03-01 - 2022-11-01: Всероссийский государственный университет юстиции, Иркутск. Должность: Технический специалист. Достижения: В рамках "Импортозамещения с Windows на Linux" настроил виртуальный сервер с Linux системой и развернул в нем раздачу по сети установщика образа на компьютеры, на что сэкономило время на установку Linux в компьютерных классах Дополнительная информация: Обязанности - работа с сайтами, поддержка функционирования серверов и сервисов СУБД, техническая поддержка пользователей. Навыки - Виртуализация, Linux, Windows.

Show more

Services:

# Администрирование виртуальных серверов.

# Администрирование локальных серверов.

# Разработка скрипта Автоматизация установки и настройки ПО.

# Разработка скрипта Восстановление флешки.

# Разработка Sql таблиц Инвентаризация техники.

# Написание Sql запросов.

# Администрирование базы данных.

Task:

Установить Hyper-V в Windows Server 2012 c помощью Shell.

# Администрирование виртуальных серверов.

Decision:

PS C:\Windows\system32> Get-Module -ListAvailable

ModuleType Version Name ExportedCo

---------- ------- ---- ----------

...

Binary 1.1 Hyper-V {Add-VMDvd

...

PS C:\Windows\system32> Import-Module -Name Hyper-V

Task:

Развернуть виртуальную тестовую машину Redos в Hyber-v с помощью Powershell.

# Администрирование виртуальных серверов.

Decision:

PS C:\Windows\system32> Get-VM

Name State CPUUsage(%) MemoryAssigned(M) Uptime Status

---- ----- ----------- ----------------- ------ ------

Alt Off 0 0 00:00:00 Работает нормально

PS C:\Windows\system32> $ram=1*1024*1024*1024

PS C:\Windows\system32> $ram

1073741824

PS C:\Windows\system32> $hdd=10*1024*1024*1024

PS C:\Windows\system32> $hdd

10737418240

PS C:\Windows\system32> NEW-VM -Name Redos -MemoryStartupBytes $ram -NewVHDPath 'C:\Data\VM\Redos\Redos.vhdx'-NewVHD

SizeBytes $hdd -Path 'C:\Data\VM\Redos'

Name State CPUUsage(%) MemoryAssigned(M) Uptime Status

---- ----- ----------- ----------------- ------ ------

Redos Off 0 0 00:00:00 Работает нормально

PS C:\Windows\system32> Get-VM

Name State CPUUsage(%) MemoryAssigned(M) Uptime Status

---- ----- ----------- ----------------- ------ ------

Alt Off 0 0 00:00:00 Работает нормально

Redos Off 0 0 00:00:00 Работает нормально

PS C:\Windows\system32> Start-VM -name Redos

PS C:\Windows\system32> Get-VM

Name State CPUUsage(%) MemoryAssigned(M) Uptime Status

---- ----- ----------- ----------------- ------ ------

Alt Off 0 0 00:00:00 Работает нормально

Redos Running 0 1024 00:00:16 Работает нормально

PS C:\Windows\system32> Stop-VM Redos

Подтверждение

Hyper-V не удается завершить работу виртуальной машины Redos, так как служба интеграции по завершению работы недоступна.

Во избежание потенциальной потери данных вы можете приостановить виртуальную машину или сохранить ее состояние. Другим

вариантом является отключение виртуальной машины, но при этом возможна потеря данных.

[Y] Да - Y [N] Нет - N [S] Приостановить - S [?] Справка (значением по умолчанию является "Y"): y

PS C:\Windows\system32> Get-VM

Name State CPUUsage(%) MemoryAssigned(M) Uptime Status

---- ----- ----------- ----------------- ------ ------

Alt Off 0 0 00:00:00 Работает нормально

Redos Off 0 0 00:00:00 Работает нормально

Task:

Установить и настроить дистрибутив Redos в виртуальной машине.

# Администрирование виртуальных серверов.

Decision:

- выбираем Install - выбрать размер разделов - поменяем систему разметки LVM на Standart Portition - нажимаем на click here to create them autmaticaly - установщик автоматически разделит диск - уменьшить размер корневого раздела / и раздел /home - Меняю у них размеры - Done - интернет настроить в Network & Host Name - Ethernet переключаем тумблер - Done - software Slection - minmal install- Done - запуск

Task:

Установить виртуальный сервер AltLinux в Hyper-V.

# Администрирование виртуальных серверов.

Decision:

PS C:\Windows\system32> $ram=1*1024*1024*1024

PS C:\Windows\system32> $ram

1073741824

PS C:\Windows\system32> $hdd=10*1024*1024*1024

PS C:\Windows\system32> $hdd

10737418240

PS C:\Windows\system32> NEW-VM -Name Alt -MemoryStartupBytes $ram -NewVHDPath 'C:\Data\VM\Alt\Alt.vhdx'-NewVHD

SizeBytes $hdd -Path 'C:\Data\VM\Alt'

PS C:\Windows\system32> Start-VM -name Alt

PS C:\Windows\system32> Get-VM

Name State CPUUsage(%) MemoryAssigned(M) Uptime Status

---- ----- ----------- ----------------- ------ ------

Alt Off 0 0 00:00:00 Работает нормально

Task:

Ввод компьютера в домен Windows и изменение имени хоста.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# yum install join-to-domain

[root@hvredos ~]# join-to-domain.sh

[root@hvredos ~]# reboot

[root@hvredos ~]# hostname hvredos.tdomain.ru

[root@hvredos ~]# hostname

hvredos.tdomain.ru

[root@hvredos ~]# vim /etc/hostname

[root@hvredos ~]# cat /etc/hostname

hvredos.tdomain.ru

[root@hvredos ~]# vim /etc/hosts

[root@hvredos ~]# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

127.0.0.1 hvredos.tdomain.ru hvredos

Task:

Установка Консультант Плюс и подключение сетевых директорий с использованием automount и механизма Kerberos.

- Для подключения скрытых сетевых каталогов необходимо экранировать символ $.

- В файле /etc/krb5.conf нужно закомментировать строку (если она ещё не закомментирована).

- Создать ярлык Консультант +. В случае замедленной работы можно добавить ключ /sprocess=0. При нормальной работе, не добавляйте этот ключ. Ключ /yes необходим для подавления сообщения об ошибке [WNetGetUniversalName ...] : NO_NETWORK

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# yum install wine winetricks

# winetricks riched30 winhttp

- Wine - Wine Configuration - Графика - уберите галочку в пункте "Разрешить менеджеру окон декорировать окна". - Для запуска «Консультант Плюс» на рабочей станции подключите сетевой диск с «Консультантом» - Сделать это можно с помощью подключения сетевых директорий с использованием automount и механизма Kerberos

[root@hvredos ~]# smbclient -L hvredos -k

Sharename Type Comment

--------- ---- -------

Consultant Disk

ConsultantR Disk

S Disk

...

[root@hvredos ~]# yum install cifs-utils autofs

[root@hvredos ~]# klist

Ticket cache: FILE:/tmp/krb5cc_1

Default principal: tuser@tdomain.ru

Valid starting Expires service principal

31.08.2020 09:51:47 31.08.2020 19:51:47 krbtgt/tdomain.ru@tdomain.ru

renew until 31.08.2020 19:51:47

[root@hvredos ~]# vim /etc/auto.master

[root@hvredos ~]# cat /etc/auto.master

...

/mnt/.hpwindows /etc/auto.samba --ghost

[root@hvredos ~]# vim /etc/auto.samba

[root@hvredos ~]# cat /etc/auto.samba

Students -fstype=cifs,multiuser,cruid=tuser,sec=krb5,domain=tdomain.ru,vers=2.1 ://hpwindows/Students

[root@hvredos ~]# vim /etc/auto.samba

[root@hvredos ~]# cat /etc/auto.samba

Consultant -fstype=cifs,multiuser,cruid=tuser,sec=krb5,domain=tdomain.ru,vers=2.1 ://hpwindows/Consultant\$

[root@hvredos ~]# cat /etc/krb5.conf

...

default_ccache_name = KEYRING:persistent:%{uid}

...

[root@hvredos ~]# vim/etc/krb5.conf

[root@hvredos ~]# cat /etc/krb5.conf

...

default_ccache_name = FILE:/tmp/krb5cc_%{uid}

...

[root@hvredos ~]# systemctl start autofs.service

[root@hvredos ~]# systemctl enable autofs --now

[root@hvredos ~]# ls /mnt/.hpwindows/Consultant/

... cons.exe ...

[root@hvredos ~]# winecfg

[root@hvredos ~]# wine /mnt/.hpwindows/Сonsultant/cons.exe /linux /yes

[root@hvredos ~]# vim /home/tuser@tdomain.ru/Рабочий\ стол/Consultant.desktop

[root@hvredos ~]# cat /home/tuser@tdomain.ru/Рабочий\ стол/Consultant.desktop

[Desktop Entry]

Name=ConsultantPlus

Exec=wine /mnt/.hpwindows/Сonsultant/cons.exe

Type=Application

StartupNotify=true

Comment=ConsultantPlus

icon=43D4_Cons.0

StartupWMClass=c.exe

Task:

Создание ярлыка для сетевой директории

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# ln -s /mnt/.hvredos/S /home/tuser@tdomain.ru/Рабочий\ стол/S

Task:

Oграничение доступа к USB накопителям.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# vim /etc/udev/rules.d/99-usb.rules

[root@hvredos ~]# cat /etc/udev/rules.d/99-usb.rules

ENV{ID_USB_DRIVER}=="usb-storage",ENV{UDISKS_IGNORE}="1"

# udevadm control --reload-rules

Task:

Запрет создания ярлыков и файлов на рабочем столе.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# tune2fs -l /dev/sda1 | grep "Default mount options:"

Default mount options: user_xattr acl

[root@hvredos ~]# vim /home/tuser@tdomain.ru/.config/user-dirs.dirs

[root@hvredos ~]# cat /home/tuser@tdomain.ru/.config/user-dirs.dirs

# This file is written by xdg-user-dirs-update

# If you want to change or add directories, just edit the line you're

# interested in. All local changes will be retained on the next run

# Format is XDG_xxx_DIR="$HOME/yyy", where yyy is a shell-escaped

# homedir-relative path, or XDG_xxx_DIR="/yyy", where /yyy is an

# absolute path. No other format is supported.

#

XDG_DESKTOP_DIR="$HOME/Рабочий стол"

XDG_DOWNLOAD_DIR="$HOME/Загрузки"

XDG_TEMPLATES_DIR="$HOME/Шаблоны"

XDG_PUBLICSHARE_DIR="$HOME/Общедоступные"

XDG_DOCUMENTS_DIR="$HOME/Документы"

XDG_MUSIC_DIR="$HOME/Музыка"

XDG_PICTURES_DIR="$HOME/Изображения"

XDG_VIDEOS_DIR="$HOME/Видео"

[root@hvredos ~]# ls -la /home/tuser@tdomain.ru/.config

...

-rw-------. 1 tuser ïîëüçîâàòåëè äîìåíà 714 àâã 31 09:52 user-dirs.dirs

-rw-r--r--. 1 tuser ïîëüçîâàòåëè äîìåíà 5 àâã 31 09:52 user-dirs.locale

[root@hvredos ~]# chown root:root /home/tuser@tdomain.ru/.config/user-dirs.dirs

[root@hvredos ~]# ls -la /home/tuser@tdomain.ru/.config

...

-rw-------. 1 root root 714 àâã 31 09:52 user-dirs.dirs

-rw-r--r--. 1 tuser ïîëüçîâàòåëè äîìåíà 5 àâã 31 09:52 user-dirs.locale

[root@hvredos ~]# ls -la

...

drwxr-xr-x. 2 tuser ïîëüçîâàòåëè äîìåíà 4096 àâã 31 09:52 'Рабочий стол'

...

[root@hvredos ~]# chown -R root:root /home/tuser@tdomain.ru/Рабочий\ стол/

[root@hvredos ~]# ls -la

...

drwxr-xr-x. 2 root root 4096 àâã 31 09:52 'Рабочий стол'

drwxr-xr-x. 2 tuser ïîëüçîâàòåëè äîìåíà 4096 àâã 31 09:52 Øàáëîíû

Task:

Как скрыть пользователей от экрана входа.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# cat /var/lib/AccountsService/users/user

[User]

Language=

XSession=

SystemAccount=false

[root@hvredos ~]# vim /var/lib/AccountsService/users/user

[root@hvredos ~]# cat /var/lib/AccountsService/users/user

[User]

Language=

XSession=gnome

SystemAccount=true

Task:

Добавление пользователя из доменной сети.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# vim /var/lib/AccountsService/users/user

[root@hvredos ~]# cat /var/lib/AccountsService/users/user

[User]

Language=

XSession=

Icon=/home/tuser@tdomain.ru/.face

SystemAccount=false

Task:

Отключить сетевые принтеры.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# vim /etc/avahi/avahi-daemon.conf

cat /etc/avahi/avahi-daemon.conf

# This file is part of avahi.

...

enable-dbus=no

...

[root@hvredos ~]# reboot

Task:

Настройка оповещения и автоматического обновления пакетов в РЕД ОС с помощью yum-cron.

- Если не требуется обновлять определенные пакеты (как вручную, так и автоматически), то добавляем их в исключение. Например, kernel и php.

- Если не требуется обновлять пакеты ТОЛЬКО в автоматическом режиме, тогда в /etc/yum/yum-cron.conf , в раздел [base]

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# yum -y install yum-cron

[root@hvredos ~]# vim /etc/yum/yum-cron.conf

[root@hvredos ~]# cat /etc/yum/yum-cron.conf

[commands]

...

apply_updates = no

[root@hvredos ~]# vim /etc/yum/yum-cron.conf

[root@hvredos ~]# cat /etc/yum/yum-cron.conf

[commands]

...

apply_updates = yes

[root@hvredos ~]# systemctl enable yum-cron --now

[root@hvredos ~]# nano /etc/yum.conf

exclude=kernel, php

[root@hvredos ~]# nano /etc/yum/yum-cron.conf

exclude=kernel* php*

Task:

Развернуть Pxe сервер для развертывания Redos с загрузкой в Uefi по сети.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# ifconfig

enp2s0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet tipwindowsserver netmask Mask1 broadcast IpAddr.255

...

[root@hvredos ~]# dnf install dhcp tftp-server syslinux httpd dnf-plugins-core -y

[root@hvredos ~]# mkdir /var/lib/tftpboot/pxelinux.cfg

[root@hvredos ~]# mkdir /var/lib/tftpboot/uefi

[root@hvredos ~]# mkdir -p /var/lib/tftpboot/images/REDOS

[root@hvredos ~]# cp /usr/share/syslinux/{chain.c32,mboot.c32,memdisk,menu.c32,pxelinux.0,ldlinux.c32,libutil.c32} /var/lib/tftpboot/

[root@hvredos ~]# chmod 777 /var/lib/tftpboot/pxelinux.0

[root@hvredos ~]# dnf download shim-x64 grub2-efi-x64 --downloaddir=/root/

[root@hvredos ~]# cd /root/

[root@hvredos ~]# rpm2cpio shim-x64-*.rpm | cpio -dimv

[root@hvredos ~]# rpm2cpio grub2-efi-x64-*.rpm | cpio -dimv

[root@hvredos ~]# cp ./boot/efi/EFI/BOOT/BOOTX64.EFI /var/lib/tftpboot/uefi

[root@hvredos ~]# cp ./boot/efi/EFI/redos/grubx64.efi /var/lib/tftpboot/uefi

[root@hvredos ~]# chmod 777 /var/lib/tftpboot/uefi/*.*

[root@hvredos ~]# umount -t iso9660 -o loop redos-MUROM-7.3.2-20211027.0-Everything-x86_64-DVD1.iso /mnt/

[root@hvredos ~]# cp -vR /mnt/* /var/lib/tftpboot/images/REDOS/

[root@hvredos ~]# umount /mnt/

[root@hvredos ~]# vim /etc/dhcp/dhcpd.conf

[root@hvredos ~]# cat /etc/dhcp/dhcpd.conf

non-authoritative;

allow bootp;

option space pxelinux;

option pxelinux.magic code 208 = string;

option pxelinux.configfile code 209 = text;

option pxelinux.pathprefix code 210 = text;

option pxelinux.reboottime code 211 = unsigned integer 32;

option architecture-type code 93 = unsigned integer 16;

subnet tipwindowsserver.0 netmask Mask1 {

option routers tipwindowsserver;

range tipwindowsserver.70 tipwindowsserver.80;

class "pxeclients" {

match if substring (option vendor-class-identifier, 0, 9) = "PXEClient";

next-server tipwindowsserver;

if option architecture-type = 00:07 {

filename "uefi/grubx64.efi";

}

else {

filename "pxelinux.0";

}

}

}

# systemctl enable dhcpd --now

[root@hvredos ~]# vim /var/lib/tftpboot/pxelinux.cfg/default

[root@hvredos ~]# cat /var/lib/tftpboot/pxelinux.cfg/default

default menu.c32

PROMPT 0

TIMEOUT 150

MENU TITLE PXE Menu

LABEL REDOS 7.3

MENU LABEL REDOS 7.3

KERNEL images/REDOS/images/pxeboot/vmlinuz

APPEND initrd=images/REDOS/images/pxeboot/initrd.img ramdisk_size=128000 ip=dhcp inst.repo=http://tipwindowsserver/images/REDOS/

[root@hvredos ~]# vim /var/lib/tftpboot/uefi/grub.cfg

[root@hvredos ~]# cat /var/lib/tftpboot/uefi/grub.cfg

function load_video {

insmod efi_gop

insmod efi_uga

insmod video_bochs

insmod video_cirrus

insmod all_video

}

load_video

set gfxpayload=keep

insmod gzio

menuentry 'REDOS 7.3' {

linux images/REDOS/images/pxeboot/vmlinuz ip=dhcp inst.repo=http://tipwindowsserver/images/REDOS/

initrd images/REDOS/images/pxeboot/initrd.img

}

Task:

Используем web-сервер для публикации файлов дистрибутива РЕД ОС в локальной сети.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# vim /etc/httpd/conf.d/pxeboot.conf

[root@hvredos ~]# cat /etc/httpd/conf.d/pxeboot.conf

Alias /images /var/lib/tftpboot/images

<Directory /var/lib/tftpboot/images>

Options Indexes FollowSymLinks

Require ip 127.0.0.1 tipwindowsserver.0/24

</Directory>

[root@hvredos ~]# systemctl enable httpd --now

Task:

Настройка и запуск службы tftp.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# vim /usr/lib/systemd/system/tftp.service

[root@hvredos ~]# cat /usr/lib/systemd/system/tftp.service

...

[Install]:

WantedBy=multi-user.target

Also=tftp.socket

...

[root@hvredos ~]# vim /usr/lib/systemd/system/tftp.socket

[root@hvredos ~]# cat /usr/lib/systemd/system/tftp.socket

...

[Unit]

Description=Tftp Server Activation Socket

[Socket]

ListenDatagram=0.0.0.0:69

[Install]

WantedBy=sockets.target

...

[root@hvredos ~]# systemctl daemon-reload

[root@hvredos ~]# systemctl enable tftp --now

[root@hvredos ~]# ausearch -c 'httpd' --raw | audit2allow -M my-httpd

[root@hvredos ~]# semodule -i my-httpd.pp

Task:

Автоматизация развертывания (kickstart)

Создать файл kickstart, Записать файл на локальный или удаленный носитель, Создать загрузочный диск, с которого будет запускаться установка, Предоставить доступ к установочной структуре, Начать процесс установки.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# dnf install pykickstart -y

[root@hvredos ~]# cp /root/anaconda-ks.cfg /var/lib/tftpboot

[root@hvredos ~]# mv /var/lib/tftpboot/anaconda-ks.cfg /var/lib/tftpboot/ks.cfg

[root@hvredos ~]# vim /var/lib/tftpboot/pxelinux.cfg/default

[root@hvredos ~]# cat /var/lib/tftpboot/pxelinux.cfg/default

...

APPEND initrd=images/REDOS/images/pxeboot/initrd.img ramdisk_size=128000 ip=dhcp method=http://tipwindowsserver/images/REDOS/ devfs=nomount inst.ks=http://tipwindowsserver/ks.cfg

[root@hvredos ~]# vim /var/lib/tftpboot/uefi/grub.cfg

[root@hvredos ~]# cat /var/lib/tftpboot/uefi/grub.cfg

... {

linux images/REDOS/images/pxeboot/vmlinuz ip=dhcp kernel vmlinuz inst.repo=http://tipwindowsserver/images/REDOS/ inst.ks=http://tipwindowsserver/ks.cfg

initrd images/REDOS/images/pxeboot/initrd.img

}

[root@hvredos ~]# vim /var/lib/tftpboot/ks.cfg

[root@hvredos ~]# cat /var/lib/tftpboot/ks.cfg

# Здесь указываем раскладку клавиатуры

keyboard --vckeymap=us --xlayouts='us','ru' --switch='grp:alt_shift_toggle'

# Системная локаль

lang ru_RU.UTF-8

# Информация о сетевом интерфейсе и имя машины

network --bootproto=dhcp --device=enp2s0 --noipv6 --activate

network --hostname=hostname1337

# Пароль Root представлен в виде хэш-суммы

rootpw --iscrypted $6$DUu0yyOYMRbGS8gL$9zHYPsxROGEZdDKG0wnf7h8SGnKOp3V272De6oGTVUsz2uBLmEeiR6T6cInRN5dyWcxNXh5fVluEUTQ/3rmzB0

# Настройка сервисов (в данном случае сервис по обновлению меток времени и дат)

services --enabled="chronyd"

# Настройка временной зоны

timezone Europe/Moscow --isUtc

#Настройка локального пользователя

user --groups=wheel --name=mekka --password=$6$83fyYZ7KMS7G9t6A$E5/99/ffOwjUOo8THr1ngqGDdKMimpTZf3IT9S/SI98BTV7dta7GksLYnQEZjtqqyZQrwibSRlvYccRqHB7m8/ --iscrypted --gecos="Mekka"

# Настройка xorg при загрузке

xconfig --startxonboot

# Указание загрузочного сектора и тип структуры

bootloader --location=mbr --boot-drive=sda

# Удаление всей информации с партиций для последующей установки

clearpart --none --initlabel

# Здесь указана вся разметка диска

part /boot --fstype="xfs" --onpart=sda2

part biosboot --fstype="biosboot" --noformat --onpart=sda4

part pv.31 --fstype="lvmpv" --noformat --onpart=sda3

part /boot/efi --fstype="efi" --onpart=sda1 --fsoptions="umask=0077,shortname=winnt"

volgroup ro --noformat --useexisting

logvol swap --fstype="swap" --useexisting --name=swap --vgname=ro

logvol /home --fstype="xfs" --noformat --useexisting --name=home --vgname=ro

logvol / --fstype="ext4" --useexisting --name=root --vgname=ro

#дополнительные пакеты для установки

%packages

@^mate-desktop-environment

@backup-client

@base

@branding

@core

@desktop-debugging

@dial-up

@directory-client

@fonts

@guest-agents

@guest-desktop-agents

@input-methods

@internet-applications

@internet-browser

@java-platform

@mate-desktop

@multimedia

@network-file-system-client

@print-client

@x11

chrony

%end

#настройка аварийных дампов памяти в случае сбоев (оставить как есть)

%addon com_redhat_kdump --enable --reserve-mb='auto'

%end

#настройка анаконды (оставить как есть)

%anaconda

pwpolicy root --minlen=6 --minquality=1 --notstrict --nochanges --notempty

pwpolicy user --minlen=6 --minquality=1 --notstrict --nochanges --emptyok

pwpolicy luks --minlen=6 --minquality=1 --notstrict --nochanges --notempty

%end

Task:

Настройка установки РЕД ОС по PXE через VNC вместо Kickstart.

# Администрирование локальных серверов.

Decision:

[root@hvredos ~]# vim /var/lib/tftpboot/pxelinux.cfg/default

[root@hvredos ~]# cat /var/lib/tftpboot/pxelinux.cfg/default

...

APPEND initrd=images/REDOS/images/pxeboot/initrd.img ramdisk_size=128000 ip=dhcp method=http://tipwindowsserver/images/REDOS/ devfs=nomount inst.vnc inst.vncpassword=tpassword

[root@hvredos ~]# vim /var/lib/tftpboot/uefi/grub.cfg

[root@hvredos ~]# cat /var/lib/tftpboot/uefi/grub.cfg

... {

linux images/REDOS/images/pxeboot/vmlinuz ip=dhcp kernel vmlinuz inst.repo=http://tipwindowsserver/images/REDOS/ inst.vnc inst.vncpassword=tpassword

initrd images/REDOS/images/pxeboot/initrd.img

}

Source:

# https://redos.red-soft.ru/base/other-soft/other-other/consultant/?sphrase_id=53349

# https://wtuseri.astralinutdomain.ru/pages/viewpage.action?pageId=61574227

# https://askubuntu.ru/questions/21203/kak-skry-t-pol-zovatelej-ot-e-krana-vxoda-v-gdm

# https://computingforgeeks.com/how-to-install-gimp-on-centos-rhel-8-desktop/

# https://ru.wtuserihow.com/%D1%81%D0%BE%D0%B7%D0%B4%D0%B0%D1%82%D1%8C-ISO-%D1%84%D0%B0%D0%B9%D0%BB-%D0%B2-Linux

# https://losst.ru/zapis-diskov-v-ubuntu

# https://losst.ru/luchshie-analogi-paint-dlya-linux

# https://computingforgeeks.com/how-to-install-anydesk-on-centos-rhel-8/

Task:

Set up an ActiveDirectory/Login.

# Администрирование локальных серверов.

Decision:

root@hvalt:~# apt-get install task-auth-ad-sssd

root@hvalt:~# net time set -S tdomain.ru

# system-auth write ad tdomain.ru hvalt hvalt 'tuser' 'tpassword'

Using short domain name -- hvalt

Joined 'hvalt' to dns domain 'tdomain.ru'

Successfully registered hostname with DNS

failed to call wbcGetDisplayName: WBC_ERR_WINBIND_NOT_AVAILABLE

Could not lookup sid S-1-5-21-965402400-3010625364-1855727791-513

failed to call wbcGetDisplayName: WBC_ERR_WINBIND_NOT_AVAILABLE

Could not lookup sid S-1-5-21-965402400-3010625364-1855727791-512

root@hvalt:~# wbinfo -t

checking the trust secret for domain hvredos via RPC calls succeeded

root@hvalt:~# acc

2 keyboards found

qt.qpa.xcb: could not connect to display

qt.qpa.plugin: Could not load the Qt platfohvredos plugin "xcb" in "" even though it was found.

This applhvredosation failed to start because no Qt platfohvredos plugin could be initialized. Reinstalling the applhvredosation may fix this problem.

Available platfohvredos plugins are: eglfs, linuxfb, minimal, minimalegl, offscreen, vnc, xcb.

root@hvalt:~# exit

root@hvalt:~# exit

[root@hvredos ~]# ssh -X tuser@hvalt

root@hvalt:~# su -

root@hvalt:~# acc

2 keyboards found

QStandardPaths: XDG_RUNTIME_DIR not set, defaulting to '/tmp/.private/root/runtime-root'

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

WARNING: (alterator lookout evaluation): imported module (alterator presentation events) overrides core binding `when'

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

libpng warning: hvredosCP: known incorrect sRGB profile

root@hvalt:~# vim /etc/net/ifaces/eth0/resolv.conf

root@hvalt:~# cat /etc/net/ifaces/eth0/resolv.conf

nameserver tipwindowsserver

root@hvalt:~# hostnamectl set-hostname hvalt.tdomain.ru

root@hvalt:~# cat /etc/resolv.conf

search tdomain.ru

nameserver 127.0.0.1

root@hvalt:~# vim /etc/resolv.conf

root@hvalt:~# cat /etc/resolv.conf

# Configuration for resolv(8)

# See resolv.conf(5) for details

resolv_conf_head='# Do not edit manually, use\n# /etc/net/ifaces/<interface>/resolv.conf instead.'

resolv_conf=/etc/resolv.conf

# These interfaces will always be processed first.

interface_order='lo lo[0-9]* lo.*'

# These interfaces will be processed next, unless they have a metrhvredos.

dynamhvredos_order='tap[0-9]* tun[0-9]* vpn vpn[0-9]* wg[0-9]* ppp[0-9]* ippp[0-9]*'

#Configuration files for named subscriber.

named_zones=/var/lib/bind/etc/resolv-zones.conf

named_options=/var/lib/bind/etc/resolv-options.conf

#Configuration files for dnsmasq subscriber.

dnsmasq_conf=/etc/dnsmasq.conf.d/60-resolv

dnsmasq_resolv=/etc/resolv.conf.dnsmasq

name_servers=127.0.0.1

root@hvalt:~# vim /etc/resolv.conf

root@hvalt:~# cat /etc/resolv.conf

# Configuration for resolv(8)

# See resolv.conf(5) for details

resolv_conf_head='# Do not edit manually, use\n# /etc/net/ifaces/<interface>/resolv.conf instead.'

resolv_conf=/etc/resolv.conf

# These interfaces will always be processed first.

#interface_order='lo lo[0-9]* lo.*'

interface_order='lo lo[0-9]* lo.* eth0'

search_domains=tdomain.ru

# These interfaces will be processed next, unless they have a metrhvredos.

dynamhvredos_order='tap[0-9]* tun[0-9]* vpn vpn[0-9]* wg[0-9]* ppp[0-9]* ippp[0-9]*'

#Configuration files for named subscriber.

named_zones=/var/lib/bind/etc/resolv-zones.conf

named_options=/var/lib/bind/etc/resolv-options.conf

#Configuration files for dnsmasq subscriber.

dnsmasq_conf=/etc/dnsmasq.conf.d/60-resolv

dnsmasq_resolv=/etc/resolv.conf.dnsmasq

#name_servers=127.0.0.1

root@hvalt:~# resolv -u

root@hvalt:~# cat /etc/resolv.conf

# Generated by resolv

# Do not edit manually, use

# /etc/net/ifaces/<interface>/resolv.conf instead.

search tdomain.ru

nameserver tipwindowsserver

...

nameserver 8.8.8.8

root@hvalt:~# hostname

hvalt.tdomain.ru

root@hvalt:~# dig _kerberos._udp.tdomain.ru SRV | grep ^_kerberos

_kerberos._udp.tdomain.ru. 600 IN SRV 0 100 88 M-1.tdomain.ru.

...

_kerberos._udp.tdomain.ru. 600 IN SRV 0 100 88 T-1.tdomain.ru.

root@hvalt:~# dig _kerberos._tcp.tdomain.ru SRV | grep ^_kerberos

_kerberos._tcp.tdomain.ru. 600 IN SRV 0 100 88 M-c.tdomain.ru.

...

_kerberos._tcp.tdomain.ru. 600 IN SRV 0 100 88 T-1.tdomain.ru.

root@hvalt:~# cat /etc/krb5.conf | grep default_realm

default_realm = tdomain.ru

# default_realm = EXAMPLE.COM

root@hvalt:~# cat /etc/krb5.conf | grep dns_lookup_realm

dns_lookup_realm = false

root@hvalt:~# cat /etc/krb5.conf | grep dns_lookup_kdc

dns_lookup_kdc = true

root@hvalt:~# exit

[root@hvredos ~]# ssh -X tuser@hvalt

root@hvalt:~# kinit tuser

root@hvalt:~# klist

Thvredosket cache: KEYRING:persistent:0:krb_ccache_CCjHpN1

Default principal: a-r@tdomain.ru

Valid starting Expires Servhvredose principal

10.08.2022 12:30:34 10.08.2022 22:30:34 krbtgt/tdomain.ru@tdomain.ru

renew until 17.08.2022 12:30:32

root@hvalt:~# apt-get install samba-client

root@hvalt:~# cat /etc/samba/smb.conf | grep realm

realm = tdomain.ru

root@hvalt:~# cat /etc/samba/smb.conf | grep workgroup

workgroup = hvalt

root@hvalt:~# cat /etc/samba/smb.conf | grep netbios

netbios name = hvalt

root@hvalt:~# cat /etc/samba/smb.conf | grep security

security = ads

root@hvalt:~# cat /etc/samba/smb.conf | grep method

kerberos method = system keytab

root@hvalt:~# cat /etc/samba/smb.conf | grep idmap

idmap config * : range = 200000-2000200000

idmap config * : backend = sss

root@hvalt:~# vim /etc/samba/smb.conf

root@hvalt:~# cat /etc/samba/smb.conf | grep idmap

idmap config * : range = 200000-2000200000

; idmap config * : backend = sss

idmap config * : backend = tdb

# testpahvalt

Load smb config files from /etc/samba/smb.conf

Loaded servhvredoses file OK.

Weak crypto is allowed

Server role: ROLE_DOMAIN_MEMBER

Press enter to see a dump of your servhvredose definitions

# Global parameters

[global]

kerberos method = system keytab

machine password timeout = 0

realm = tdomain.ru

security = ADS

template homedir = /home/tdomain.ru/%U

template shell = /bin/bash

winbind use default domain = Yes

workgroup = hvredos

idmap config * : range = 200000-2000200000

idmap config * : backend = tdb

[share]

comment = Commonplace

path = /srv/share

read only = No

[homes]

browseable = No

comment = Home Directory for '%u'

read only = No

root@hvalt:~# cat /etc/hosts

127.0.0.1 localhost.localdomain localhost

root@hvalt:~# vim /etc/hosts

root@hvalt:~# cat /etc/hosts

127.0.0.1 hvalt.tdomain.ru hvalt

root@hvalt:~# net ads join -U tuser

Enter tuser's password:

Using short domain name -- hvalt

Joined 'hvalt' to dns domain 'tdomain.ru'

root@hvalt:~# klist -k -e

Keytab name: FILE:/etc/krb5.keytab

KVNO Principal

---- --------------------------------------------------------------------------

9 host/hvalt.tdomain.ru@tdomain.ru (aes256-cts-hmac-sha1-96)

9 host/hvalt@tdomain.ru (aes256-cts-hmac-sha1-96)

9 host/hvalt.tdomain.ru@tdomain.ru (aes128-cts-hmac-sha1-96)

9 host/hvalt@tdomain.ru (aes128-cts-hmac-sha1-96)

9 host/hvalt.tdomain.ru@tdomain.ru (DEPRECATED:arcfour-hmac)

9 host/hvalt@tdomain.ru (DEPRECATED:arcfour-hmac)

9 hvalt$@tdomain.ru (aes256-cts-hmac-sha1-96)

9 hvalt$@tdomain.ru (aes128-cts-hmac-sha1-96)

9 hvalt$@tdomain.ru (DEPRECATED:arcfour-hmac)

8 host/hvalt.tdomain.ru@tdomain.ru (aes256-cts-hmac-sha1-96)

8 host/hvalt@tdomain.ru (aes256-cts-hmac-sha1-96)

8 host/hvalt.tdomain.ru@tdomain.ru (aes128-cts-hmac-sha1-96)

8 host/hvalt@tdomain.ru (aes128-cts-hmac-sha1-96)

8 host/hvalt.tdomain.ru@tdomain.ru (DEPRECATED:arcfour-hmac)

8 host/hvalt@tdomain.ru (DEPRECATED:arcfour-hmac)

8 hvalt$@tdomain.ru (aes256-cts-hmac-sha1-96)

8 hvalt$@tdomain.ru (aes128-cts-hmac-sha1-96)

8 hvalt$@tdomain.ru (DEPRECATED:arcfour-hmac)

root@hvalt:~# apt-get install sssd-ad

root@hvalt:~# cat /etc/sssd/sssd.conf

[sssd]

config_file_version = 2

servhvredoses = nss, pam

# Managed by system facility command:

## control sssd-drop-privileges unprivileged|privileged|default

user = _sssd

# SSSD will not start if you do not configure any domains.

domains = tdomain.ru

[nss]

[pam]

[domain/tdomain.ru]

id_provider = ad

auth_provider = ad

chpass_provider = ad

access_provider = ad

default_shell = /bin/bash

fallback_homedir = /home/%d/%u

debug_level = 0

; cache_credentials = false

ad_gpo_ignore_unreadable = true

ad_gpo_access_control = pehvredosissive

ad_update_samba_machine_account_password = true

root@hvalt:~# vim /etc/sssd/sssd.conf

root@hvalt:~# cat /etc/sssd/sssd.conf

[sssd]

config_file_version = 2

servhvredoses = nss, pam

# Managed by system facility command:

## control sssd-drop-privileges unprivileged|privileged|default

#user = _sssd

user=root

# SSSD will not start if you do not configure any domains.

domains = tdomain.ru

[nss]

[pam]

[domain/tdomain.ru]

id_provider = ad

auth_provider = ad

chpass_provider = ad

access_provider = ad

;ldap_id_mapping = False

default_shell = /bin/bash

fallback_homedir = /home/%d/%u

debug_level = 0

;use_fully_qualified_names = True

; cache_credentials = True

ad_gpo_ignore_unreadable = true

ad_gpo_access_control = pehvredosissive

ad_update_samba_machine_account_password = true

root@hvalt:~# grep sss /etc/nsswitch.conf

passwd: files sss

shadow: tcb files sss

group: files [SUCCESS=merge] sss role

root@hvalt:~# control system-auth sss

root@hvalt:~# servhvredose sssd status

active

root@hvalt:~# servhvredose sssd start

root@hvalt:~# getent passwd tuser

tuser:*:1-9:1-3:в-н:/home/tdomain.ru/tuser:/bin/bash

root@hvalt:~# id tuser

uid=1-9(tuser) gid=1-3(пользователи домена) группы=1-3(пользователи домена),1-8(администраторы dhcp),1-0(tuser),11-0(пользователи филиалы),1-1(tuser),1-9(i-n)

root@hvalt:~# net ads info

LDAP server: IpAddr2

LDAP server name: MOW-1.tdomain.ru

Realm: tdomain.ru

Bind Path: dc=hvalt,dc=RU

LDAP port: 389

Server time: Ср, 10 авг 2022 13:08:06 +08

KDC server: IpAddr2

Server time offset: 0

Last machine account password change: Ср, 10 авг 2022 12:50:51 +08

root@hvalt:~# net ads testjoin

Join is OK

root@hvalt:~# cat /etc/lightdm/lightdm.conf | grep greeter-hide-

# greeter-hide-users = True to hide the user list

#greeter-hide-users=false

greeter-hide-users = true

root@hvalt:~# cat /etc/lightdm/lightdm-gtk-greeter.conf | grep show-language

show-language-selector = false

root@hvalt:~# cat /etc/lightdm/lightdm-gtk-greeter.conf | grep show-indhvredosators

root@hvalt:~# vim /etc/lightdm/lightdm-gtk-greeter.conf

root@hvalt:~# cat /etc/lightdm/lightdm-gtk-greeter.conf | grep show-indhvredosators

show-indhvredosators=~a11y;~power;~session;~language

root@hvalt:~# vim /etc/lightdm/lightdm-gtk-greeter.conf

root@hvalt:~# cat /etc/lightdm/lightdm-gtk-greeter.conf | grep enter-

enter-username = true

root@hvalt:~# reboot

Task:

Учетные записи и групп в Альт Линукс.

# Администрирование локальных серверов.

Decision:

root@hvalt:~# apt-get install libnss-role

root@hvalt:~# groupadd -r localadmins

groupadd: группа «localadmins» уже существует

root@hvalt:~# groupadd -r remote

groupadd: группа «remote» уже существует

root@hvalt:~# control sshd-allow-groups enabled

root@hvalt:~# sed -i 's/AllowGroups.*/AllowGroups = remote/' /etc/openssh/sshd_config

root@hvalt:~# roleadd users cdwriter cdrom audio proc radio camera floppy xgrp scanner uucp fuse

root@hvalt:~# roleadd localadmins wheel remote vboxusers

root@hvalt:~# roleadd 'Domain Users' users

Error 156: No such group

root@hvalt:~# roleadd 'Пользователи домена' users

root@hvalt:~# roleadd 'Администраторы домена' localadmins

root@hvalt:~# rolelst

users:cdwriter,cdrom,audio,proc,radio,camera,floppy,xgrp,scanner,uucp,fuse,video,vboxusers,vboxadd

localadmins:wheel,remote,vboxusers,vboxadd

пользователи домена:users

администраторы домена:localadmins

powerusers:remote,vboxadd,vboxusers

vboxadd:vboxsf

root@hvalt:~# id tuser

uid=1-9(tuser) gid=1-3(пользователи домена) группы=1-3(пользователи домена),11-0(пользователи филиалы),1-9(i-n),1-0(tuser),1-1(tuser),1-8(администраторы dhcp),100(users),80(cdwriter),22(cdrom),81(audio),19(proc),83(radio),440(camera),71(floppy),466(xgrp),467(scanner),14(uucp),483(fuse),488(video),481(vboxusers),455(vboxadd),454(vboxsf)

root@hvalt:~# roleadd 'tuser' localadmins

root@hvalt:~# roleadd 'tuser' wheel

root@hvalt:~# rolelst

users:cdwriter,cdrom,audio,proc,radio,camera,floppy,xgrp,scanner,uucp,fuse,video,vboxusers,vboxadd

localadmins:wheel,remote,vboxusers,vboxadd

пользователи домена:users

администраторы домена:localadmins

tuser:localadmins

powerusers:remote,vboxadd,vboxusers

vboxadd:vboxsf

root@hvalt:~# exit

[root@hvredos ~]# ssh -X tuser@hvalt

root@hvalt:~# id tuser

uid=1-9(tuser) gid=1-3(пользователи домена) группы=1-3(пользователи домена),11-0(пользователи филиалы),1-9(i-n),1-0(tuser),1-1(tuser),1-8(администраторы dhcp),100(users),80(cdwriter),22(cdrom),81(audio),19(proc),83(radio),440(camera),71(floppy),466(xgrp),467(scanner),14(uucp),483(fuse),488(video),481(vboxusers),455(vboxadd),454(vboxsf),101(localadmins),10(wheel),110(remote)

Task:

Добавить сетевые папки.

# Администрирование локальных серверов.

Decision:

root@hvalt:~# apt-get install autofs

root@hvalt:~# vim /etc/auto.master

root@hvalt:~# cat /etc/auto.master

# Fohvredosat of this file:

# mountpoint map options

# For details of the fohvredosat look at autofs(8).

/mnt/auto /etc/auto.tab -t 5

/mnt/net /etc/auto.avahi -t 120

/mnt/.tdirectory /etc/auto.samba --ghost

root@hvalt:~# vim /etc/auto.samba

root@hvalt:~# cat /etc/auto.samba

s -fstype=cifs,multiuser,cruid=$USER,sec=krb5,domain=tdomain.ru,vers=1.0 ://hvalt/tdirectory1

o -fstype=cifs,multiuser,cruid=$USER,sec=krb5,domain=tdomain.ru,vers=1.0 ://hvalt/tdirectory2

root@hvalt:~# systemctl enable autofs

root@hvalt:~# systemctl start autofs

root@hvalt:~# ls -la /mnt/.tdirectory/

drwxr-xr-x 4 root root 0 авг 11 14:09 .

drwxr-xr-x 5 root root 4096 авг 11 14:09 ..

d????????? ? ? ? ? ? o

d????????? ? ? ? ? ? s

Task:

Creating a Network Bridge interface.

# Администрирование локальных серверов.

Decision:

root@hvalt:~# mkdir /etc/net/ifaces/tethernet1

root@hvalt:~# cp /etc/net/ifaces/tethernet/* /etc/net/ifaces/tethernet1

root@hvalt:~# rm -f /etc/net/ifaces/tethernet/{i,r}*

root@hvalt:~# ls /etc/net/ifaces/tethernet1/

ipv4address options resolv.conf

root@hvalt:~# cat /etc/net/ifaces/tethernet1/options

BOOTPROTO=dhcp

TYPE=eth

NM_CONTROLLED=yes

DISABLED=yes

CONFIG_WIRELESS=no

SYSTEMD_BOOTPROTO=dhcp4

CONFIG_IPV4=yes

SYSTEMD_CONTROLLED=no

root@hvalt:~# vim /etc/net/ifaces/tethernet1/options

root@hvalt:~# ls /etc/net/ifaces/

default tethernet lo unknown tethernet1

root@hvalt:~# vim /etc/net/ifaces/tethernet1/options

root@hvalt:~# cat /etc/net/ifaces/tethernet1/options

BOOTPROTO=static

CONFIG_WIRELESS=no

CONFIG_IPV4=yes

HOST='tethernet'

ONBOOT=yes

TYPE=bri

root@hvalt:~# ls /etc/net/ifaces/tethernet/

ipv4address options resolv.conf

root@hvalt:~# service network restart

Source:

# https://www.altlinux.org/ActiveDirectory/Login#%D0%A3%D1%81%D1%82%D0%B0%D0%BD%D0%BE%D0%B2%D0%BA%D0%B0_%D0%BF%D0%B0%D0%BA%D0%B5%D1%82%D0%BE%D0%B2

# https://www.altlinux.org/SSSD/AD

# https://www.altlinux.org/%D0%A1%D0%B5%D1%82%D0%B5%D0%B2%D0%BE%D0%B9_%D0%BC%D0%BE%D1%81%D1%82

# https://www.altlinux.org/PostgreSQL#%D0%A3%D1%81%D1%82%D0%B0%D0%BD%D0%BE%D0%B2%D0%BA%D0%B0_%D0%B8_%D0%BD%D0%B0%D1%87%D0%B0%D0%BB%D1%8C%D0%BD%D1%8B%D0%B9_%D0%B7%D0%B0%D0%BF%D1%83%D1%81%D0%BA

# https://www.tecmint.com/install-postgresql-and-pgadmin-in-ubuntu/

# https://o7planning.org/11353/install-pgadmin-on-ubuntu

# https://redos.red-soft.ru/base/server-configuring/dbms/install-postgresql/?sphrase_id=53348

# https://redos.red-soft.ru/base/server-configuring/dbms/pgadmin4/

Task:

В компьютерном классе по 20 компьютеров и в каждом надо было установить Microsoft Office.

Для этого я написал скрипты инсталлятор и конфигуратор, которые позволяют мне выбрать дистрибутив, в котором я установливаю, саму программу для установки и настройки (не только офис).

# Разработка скрипта Автоматизация установки и настройки ПО.

Decision:

[root@hvredos ~]# ./InstallerOffice.sh

Do you want to install the program? (y/n) y

Select the distribution where you want to install the program (Centos 9 - 1 / Ubuntu 22.04 - 2 / Redos 7.3 - 3): 1

Select a program (Test - 0 / Sublime Text - 1 / Postgresql - 2 / PgAdmin - 3 / Git - 4 / Kvm - 5 / nfts-3g - 6 / libreoffice - 7): 0

Do you want to install the program? (y/n) y

Select the distribution where you want to install the program (Centos 9 - 1 / Ubuntu 22.04 - 2 / Redos 7.3 - 3): 2

Select a program (Test - 0 / Net-Tools - 1 / Ssh - 2): 0

[root@hvredos ~]# ./ConfigOffice.sh

Do you want to configure the program? (y/n) y

Select the distribution where you want to configure the program (Redhat - 1 / Debian - 2): 1

Select a program (Test - 0 / Disabling Lamp - 1 / Starting Lamp - 2 / Add users in postgressql - 3 / Moving linux folders to another disk - 4): 0

Do you want to configure the program? (y/n) n

Source:

# https://stackoverflow.com/questions/226703/how-do-i-prompt-for-yes-no-cancel-input-in-a-linux-shell-script

Task:

Столкнулся с такой проблемой, что маленький неттоп флешки не читает, он не был добавлен в домен и антивирус на нем не стоял.

Убедимся на другой машине, в моем случае ноутбуке, что флешка спокойно видит на нем файлы.

То есть это чистая флешка, не зараженная, и попробуем ее вставить в тот проблемный неттоп.

Тут мы увидим, что во флешке другая информация будет.

Как будто в самой флешке отображается сама флешка, и если ее открыть (что делать не стоит) тот там и будут наши файлы.

на самом деле они будут зашифрованны и флешка заражена.

# Разработка скрипта Восстановление флешки.

Decision:

- антивирус Касперский FREE - рекомендации по устранении проблм в компьютере - устранить - перезагрузиться -

- антивирус Касперский FREE - информация об устранении проблем

- вставить флешку - антвирус удалил какой-то файл (это и есть вирус)

- Открываем флешку после удаления вируса (пустой файл, хотя система показывает, что флешка заполнена, Он содержит зашифрованные файлы)

- восстановить зашифрованные файлы - Вставьте скрипт FlashDriveRecovery во флешку

Task:

Установка и настройка базы данных в PostgreSQL.

# Администрирование баз данных.

Decision:

root@hvalt:~# apt-get update

root@hvalt:~# apt-get install postgresql12-server

root@hvalt:~# /etc/init.d/postgresql initdb

root@hvalt:~# systemctl start postgresql

root@hvalt:~# systemctl enable postgresql

root@hvalt:~# pg_isready

root@hvalt:~# psql -U postgres

postgres=# CREATE USER tuser WITH PASSWORD 'tpassword';

postgres=# CREATE DATABASE tbase;

postgres=# GRANT ALL PRIVILEGES ON DATABASE tbase to tuser;

postgres=# psql -U postgres -c "\l+"

Список баз данных

Имя | Владелец | Кодировка | LC_COLLATE | LC_CTYPE | Права доступа | Размер | Табл. пространство | Опис

ание

-------------+----------+-----------+-------------+-------------+-----------------------+---------+--------------------+----------------------

----------------------

tbase | postgres | UTF8 | ru_RU.UTF-8 | ru_RU.UTF-8 | =Tc/postgres +| 8041 kB | pg_default |

| | | | | postgres=CTc/postgres+| | |

| | | | | tuser=CTc/postgres | | |

postgres | postgres | UTF8 | ru_RU.UTF-8 | ru_RU.UTF-8 | | 8185 kB | pg_default | default administrativ

e connection database

...

postgres=# \c tbase

tbase=# GRANT ALL PRIVILEGES ON ALL TABLES IN SCHEMA public TO "tuser";

tbase=# ALTER DATABASE tbase OWNER TO tuser;

tbase=# \q

root@kvmubuntu:~# apt install postgresql postgresql-contrib

root@kvmubuntu:~# usermod -aG postgres tuser

root@kvmubuntu:~# sudo -i -u postgres

postgres@kvmubuntu:~$ psql

postgres=# \q

postgres@kvmubuntu:~$ createuser --interactive

Enter name of role to add: tuser

Shall the new role be a superuser? (y/n) y

postgres@kvmubuntu:~$ createdb tbase

postgres@kvmubuntu:~$ exit

root@kvmubuntu:~# psql -U tuser -d tbase

tbase=# \password

tbase=# GRANT ALL PRIVILEGES ON DATABASE tbase to tuser;

tbase=# GRANT ALL PRIVILEGES ON ALL TABLES IN SCHEMA public TO "tuser";

tbase=# ALTER DATABASE tbase OWNER TO tuser;

tbase=# GRANT pg_read_all_settings TO tuser;

tbase=# \conninfo

You are connected to database "tbase" as user "tuser" via socket in "/var/run/postgresql" at port "5432".

tbase=# \l+

List of databases

Name | Owner | Encoding | Collate | Ctype | Access privileges | Size | Tablespace | Description

-----------+----------+----------+-------------+-------------+-----------------------+---------+------------+--------------------------------------------

tbase | tuser | UTF8 | en_US.UTF-8 | en_US.UTF-8 | =Tc/tuser +| 8561 kB | pg_default |

| | | | | tuser=CTc/tuser | | |

...

tbase=# SHOW config_file;

...

/etc/postgresql/14/main/postgresql.conf

tbase=# \q

root@kvmubuntu:~# vim /etc/postgresql/14/main/postgresql.conf

root@kvmubuntu:~# cat /etc/postgresql/14/main/postgresql.conf | grep listen_addresses

listen_addresses = 'tipubuntu' # what IP address(es) to listen on;

root@kvmubuntu:~# vim /etc/postgresql/14/main/pg_hba.conf

root@kvmubuntu:~# cat /etc/postgresql/14/main/pg_hba.conf

...

# "local" is for Unix domain socket connections only

host tbase tuser tipubuntu/32 md5

local all all peer

root@kvmubuntu:~# systemctl restart postgresql

tuser@kvmubuntu:~$ psql -U tuser -d tbase -h tipubuntu

tbase=# \d

Did not find any relations.

tbase=# \q

Source:

# https://www.digitalocean.com/community/tutorials/how-to-install-postgresql-on-ubuntu-22-04-quickstart - How To Install PostgreSQL on Ubuntu 22.04 [Quickstart].

# https://uchet-jkh.ru/i/kak-izmenit-parol-k-baze-dannyx-postgresql/ - Измените пароль для выбранного пользователя.

# https://asvignesh.in/how-to-get-the-postgresql-conf-file-location/ - Grant Role to the non-default user.

# https://postgrespro.ru/docs/postgresql/9.5/manage-ag-createdb - Создание базы данных.

Task:

Сделаем так, чтобы с клиентской машины Redos мы могли подключаться к серверу AltLinux удаленно.

# Администрирование базы данных.

Decision:

root@hvalt:~# su - postgres -c "psql -c 'SHOW config_file;'"

config_file

-------------------------------------

/var/lib/pgsql/data/postgresql.conf

(1 строка)

# echo "listen_addresses = 'IpAddr3, IpAddr2, hvalt'" >> /var/lib/pgsql/data/postgresql.conf

[root@hvredos ~]# cat /var/lib/pgsql/data/pg_hba.conf

...

# "local" is for Unix domain socket connections only

local all all trust

# IPv4 local connections:

host all all 127.0.0.1/32 trust

...

[root@hvredos ~]# vim /var/lib/pgsql/data/pg_hba.conf

[root@hvredos ~]# cat /var/lib/pgsql/data/pg_hba.conf | grep '10.38.'

# "local" is for Unix domain socket connections only

local all all trust

# IPv4 local connections:

host tbase tuser IpAddr2/21 md5

host all all 127.0.0.1/32 trust

root@hvalt:~# systemctl restart postgresql

root@hvalt:~# systemctl status postgresql

[root@hvredos ~]# psql -d tbase -U tuser -h hvalt

Task:

Для работы с базой в графическом интерфейсе установим Pgadmin.

# Администрирование базы данных.

Decision:

root@hvalt:~# apt-get install pgadmin3

root@hvalt:~# pgadmin3 &

- add server - name - tuser - host - hvalt- password - tpassword - ok

[root@hvredos ~]# dnf install postgresql-server

root@hvalt:~# postgresql-setup initdb

root@hvalt:~# systemctl enable postgresql

root@hvalt:~# systemctl start postgresql

root@hvalt:~# pg_isready

[root@hvredos ~]# psql -d tbase -U tuser -h hvalt

tbase=> \du

Список ролей

Имя роли | Атрибуты | Член ролей

----------+-------------------------------------------------------------------------+------------

tuser | | {}

postgres | Суперпользователь, Создаёт роли, Создаёт БД, Репликация, Пропускать RLS | {}

[root@hvredos ~]# dnf install pgadmin4 pgadmin4-qt

[root@hvredos ~]# pgadmin4-qt &

- root's password - add server - name - tuser - host - hvalt- password - tpassword - ok

Task:

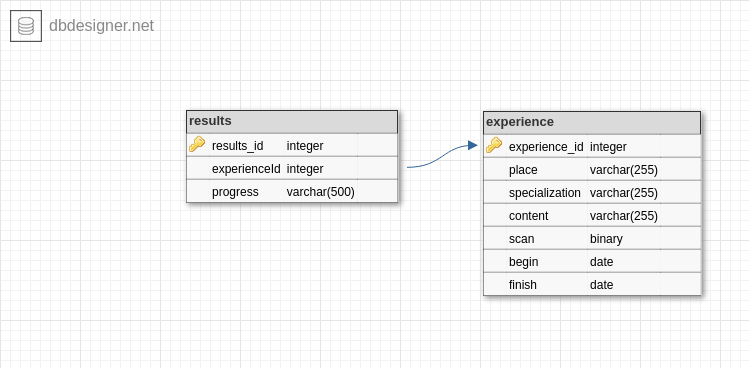

Разработать схему базы данных Инвентаризация.

# Написание Sql запросов.

Decision:

Task:

Создать таблицы.

- В первой таблице отметим в каких зданиях находятся кабинеты.

- Вторая таблица отвечает за названия оборудований.

- Третья таблица отвечает за инвентарные номера оборудований, кабинетов и даты изменения.

# Разработка Sql таблиц Инвентаризация техники.

Decision:

tbase=> SELECT * FROM offices;

+====+========+===============+

| id | office | building |

+====+========+===============+

| 1 | 1 | Улица1 |

+----+--------+---------------+

| 2 | 2 | Улица1 |

+----+--------+---------------+

...

+----+--------+---------------+

| 8 | 8 | Улица2 |

+----+--------+---------------+

| 9 | 9 | Улица2 |

+----+--------+---------------+

tbase=> SELECT * FROM devices;

+====+=================================================+======================================+

| id | device | title |

+====+=================================================+======================================+

| 1 | Atc | Panasonic kx-tda100ru |

+----+-------------------------------------------------+--------------------------------------+

| 2 | Bидеокамера белая | (null) |

+----+-------------------------------------------------+--------------------------------------+

...

+----+-------------------------------------------------+--------------------------------------+

| 39 | Усилитель мощности | Eurosound xz-400 |

+----+-------------------------------------------------+--------------------------------------+

| 40 | 8 port video splitter | (null) |

+----+-------------------------------------------------+--------------------------------------+

tbase=> SELECT * FROM inventories;

+====+=============+===========+===========+==========+=====================+

| id | inventory | device_id | office_id | quantity | date |

+====+=============+===========+===========+==========+=====================+

| 1 | 457 | 1 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 2 | (null) | 2 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

...

+----+-------------+-----------+-----------+----------+---------------------+

| 67 | 556 | 33 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 68 | 426 | 32 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

Task:

Мне нужно вывести информацию, где в первом столбце будет инвентарные номера, во втором столбце, устройство и его название, а в третьем столбце вывести кабинеты, где находятся те самые оборудования

# Написание Sql запросов.

Decision:

tbase=> SELECT inventory, device, title, office

FROM inventories

INNER JOIN devices

ON inventories.device_id = devices.id

INNER JOIN offices

ON inventories.office_id = offices.id

WHERE office_id='6';

+=============+=========================+=================+========+

| inventory | device | title | office |

+=============+=========================+=================+========+

| 008 | Колонки | Sven sps-605 | 6 |

+-------------+-------------------------+-----------------+--------+

| 707 | Мультимедийный проектор | Epson eb-965h | 6 |

+-------------+-------------------------+-----------------+--------+

| 750 | Компьютер | Nuc mini pc kit | 6 |

+-------------+-------------------------+-----------------+--------+

Task:

Заметил ошибку в таблице, есть лишнее оборудование в кабинете. его на самом деле нету в кабинете и значит не должно быть в таблице.

# Написание Sql запросов.

Decision:

tbase=> DELETE FROM inventories

WHERE id='64';

SELECT inventory, device, title, office

FROM inventories

INNER JOIN devices

ON inventories.device_id = devices.id

INNER JOIN offices

ON inventories.office_id = offices.id

WHERE office_id='6';

+===========+=========================+=================+========+

| inventory | device | title | office |

+===========+=========================+=================+========+

| 707 | Мультимедийный проектор | Epson eb-965h | 6 |

+-----------+-------------------------+-----------------+--------+

| 750 | Компьютер | Nuc mini pc kit | 6 |

+-----------+-------------------------+-----------------+--------+

tbase=> SELECT * FROM inventories;

+====+=============+===========+===========+==========+=====================+

| id | inventory | device_id | office_id | quantity | date |

+====+=============+===========+===========+==========+=====================+

| 1 | 457 | 1 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 2 | (null) | 2 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

...

+----+-------------+-----------+-----------+----------+---------------------+

| 67 | 556 | 33 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 68 | 426 | 32 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

Task:

Появилось новое обрудование, и нужно его внести в таблицу.

# Написание Sql запросов.

Decision:

tbase=> INSERT INTO inventories (inventory, device_id, office_id, quantity, date)

VALUES ('testinv1', '39', '1', '1', '2017-12-12 12:12:12');

tbase=> SELECT * FROM inventories;

+====+=============+===========+===========+==========+=====================+

| id | inventory | device_id | office_id | quantity | date |

+====+=============+===========+===========+==========+=====================+

| 1 | 457 | 1 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 2 | (null) | 2 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

...

+----+-------------+-----------+-----------+----------+---------------------+

| 68 | 426 | 32 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 69 | testinv1 | 39 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

Task:

в предыдущей задаче не верные данные внес в таблицу, нужно подкорректировать.

# Написание Sql запросов.

Decision:

tbase=> UPDATE inventories

SET inventory='testinv2', office_id='9'

WHERE id='69';

tbase=> SELECT * FROM inventories;

+====+=============+===========+===========+==========+=====================+

| id | inventory | device_id | office_id | quantity | date |

+====+=============+===========+===========+==========+=====================+

| 1 | 457 | 1 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 2 | (null) | 2 | 1 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

...

+----+-------------+-----------+-----------+----------+---------------------+

| 68 | 426 | 32 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

| 69 | testinv2 | 39 | 9 | 1 | 2017-12-12 12:12:12 |

+----+-------------+-----------+-----------+----------+---------------------+

tbase=> SELECT inventory, device, title, office

FROM inventories

INNER JOIN devices

ON inventories.device_id = devices.id

INNER JOIN offices

ON inventories.office_id = offices.id

WHERE office_id='9';

+=============+==========================+==================+========+

| inventory | device | title | office |

+=============+==========================+==================+========+

| 650 | Компьютер | Nuc | 9 |

+-------------+--------------------------+------------------+--------+

| 426 | Интерактиная доска | 80 | 9 |

+-------------+--------------------------+------------------+--------+

| 556 | Короткофокусный проектор | Benq | 9 |

+-------------+--------------------------+------------------+--------+

| 010 | Колонки | Microlab solo 1 | 9 |

+-------------+--------------------------+------------------+--------+

| testinv2 | Усилитель мощности | Eurosound xz-400 | 9 |

+-------------+--------------------------+------------------+--------+

2019-11-01 - 2021-05-30: Easy School, Иркутск. Должность: English Level Elementary A - Дополнительное образование. Достижения: Разработал программу телеграмм бот Переводчик. Дополнительная информация: Навыки - English, Python, Clouds.

Show more

Services:

# Разработка функции меню.

# Администрирование локальных серверов.

# Разработка переводчик.

# Администрирование баз данных.

# Разработка базы данных Словарь.

# Написание Sql запросов.

Task:

написать консольное меню, которая будет предлагать какие действя нужно выполнить

# Разработка Функции меню.

Decision:

root@kvmubuntu:~# python3 pyMenu.py

Привет!

Я тестовый бот.

Выбери программу, которую ты хочешь выполнить

(0, translator, dictionary): translator

Что именно нужно сделать

(translate, back): translate

Здесь программа переведет вам текст

Что именно нужно сделать

(translate, back): back

Вы вернулись в главное меню

Привет!

Я тестовый бот.

Выбери программу, которую ты хочешь выполнить

(0, translator, dictionary): dictionary

Что именно нужно сделать

(list,term,back): list

Вывести список слов

Что именно нужно сделать

(list,term,back): term

Выбрать слово их списка

Что именно нужно сделать

(list,term,back): back

Вы вернулись в главное меню

Привет!

Я тестовый бот.

Выбери программу, которую ты хочешь выполнить

(0, translator, dictionary): 0

translator

Task:

Подготовка библиотек.

# Администрирование локальных серверов.

Decision:

root@kvmubuntu:~# python3 -m venv tenv

root@kvmubuntu:~# source tenv/bin/activate

(tenv) root@kvmubuntu:~# pip install -r requirements.txt

Task:

Раработка программы переводчик.

Добавить переводчик в функцию.

# Разработка переводчик.

Decision:

(tenv) root@kvmubuntu:~# python3 translator.py

Hi, how are you?

(tenv) root@kvmubuntu:~# python3 pyTranslator1.py

Введите текст, который вы хотите перевести: Вчера я забронировал у вас номер в отеле.

Tom booked a room at the hotel

(tenv) root@kvmubuntu:~# python3 pyTranslator2.py

Введите текст, который вы хотите перевести: Вчера я забронировал у вас номер в отеле.

Yesterday I booked a hotel room with you.

(tenv) root@kvmubuntu:~# python3 pyTranslator3.py

Введите текст, который вы хотите перевести: Для тестирования работоспособности телеграм бота переводчик, написанном на Python мы использовали готовый преднастроенный телеграм бот сервер.

To test the functionality of the telegram bot translator, written in Python, we used a ready-made pre-configured telegram bot server.

(tenv) root@kvmubuntu:~# python3 pyTranslator3.py

Введите текст, который вы хотите перевести: To test the functionality of the telegram bot translator, written in Python, we used a ready-made pre-configured telegram bot server.

Для проверки работоспособности переводчика телеграмм-бота, написанного на Python, мы использовали готовый, предварительно настроенный сервер телеграм-бота.

(tenv) root@kvmubuntu:~# python3 pyTranslator3.py

Введите текст, который вы хотите перевести: ;

Я тебя не понимаю

Task:

Применение библиотеки Translator и готовой функции меню.

# Разработка переводчик.

Decision:

(tenv) root@kvmubuntu:~# python3 pyMenuTranslator.py

Привет!

Я тестовый бот.

Выбери программу, которую ты хочешь выполнить

(0, translator, dictionary): translator

Что именно нужно сделать

(translate, back): translate

Введите текст, который вы хотите перевести: Привет. Как дела?

Hi, how are you?

Что именно нужно сделать

(translate, back): back

Вы вернулись в главное меню

Привет!

Я тестовый бот.

Выбери программу, которую ты хочешь выполнить

(0, translator, dictionary): 0

translator

Task:

Установка и настройка базы данных в PostgreSQL.

# Администрирование базы данных.

Decision:

(tenv) root@kvmubuntu:~# createdb tbase2

(tenv) root@kvmubuntu:~# psql -U tuser -d tbase -h tipubuntu

tbase=# GRANT ALL PRIVILEGES ON DATABASE tbase2 to tuser;

tbase=# ALTER DATABASE tbase2 OWNER TO tuser;

tbase=# \l+

tbase | tuser | UTF8 | en_US.UTF-8 | en_US.UTF-8 | =Tc/tuser +| 9801 kB | pg_default |

| | | | | tuser=CTc/tuser | | |

tbase2 | tuser | UTF8 | en_US.UTF-8 | en_US.UTF-8 | =Tc/tuser +| 8577 kB | pg_default |

| | | | | tuser=CTc/tuser | | |

root@kvmubuntu:~# vim /etc/postgresql/14/main/pg_hba.conf

root@kvmubuntu:~# cat /etc/postgresql/14/main/pg_hba.conf

...

host tbase2 tuser tipubuntu1/24 md5

root@kvmubuntu:~# systemctl restart postgresql

Source:

# https://postgrespro.ru/docs/postgresql/9.5/manage-ag-createdb - Создание базы данных.

Task:

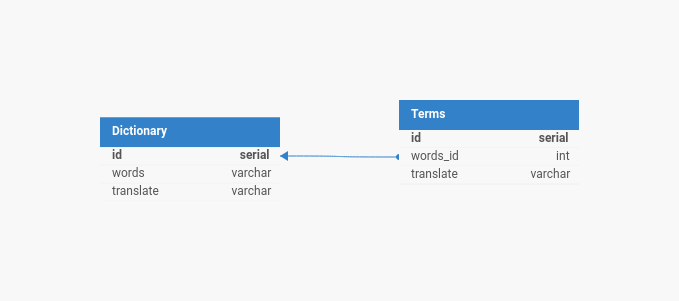

Разработать схему БД Словарь.

# Разработка базы данных Словарь.

Decision:

Task:

Разработка базы данных.

Словарь

id | words | translate

1 | Текст1 | Text1

2 | Текст2 | Text2

3 | Текст3 | Text3

Термины

id | words_id | description | translate

1 | 1 | Текст4 | Text4

2 | 3 | Текст5 | Text5

# Разработка базы данных Словарь.

Decision:

(tenv) root@kvmubuntu:~# psql -U tuser -d tbase2 -h tipubuntu

tbase2=# CREATE TABLE tbase2 (

id INT PRIMARY KEY GENERATED ALWAYS AS IDENTITY,

words VARCHAR(1000),

translate VARCHAR(1000)

);

tbase2=# CREATE TABLE Terms (

id INT PRIMARY KEY GENERATED ALWAYS AS IDENTITY,

words_id INT,

description VARCHAR(1000),

translate VARCHAR(1000),

CONSTRAINT fk_tbase2

FOREIGN KEY(words_id)

REFERENCES tbase2(id)

);

tbase2=# INSERT INTO tbase2 (words, translate)

VALUES ('Текст1', 'Text1'), ('Текст2', 'Text2'), ('Текст3', 'Text3');

tbase2=# INSERT INTO Terms (words_id, description, translate)

VALUES (1, 'Текст4', 'Text4'), (3, 'Текст5','Text5');

Task:

Написать запрос

words | translate | description | translate

Текст1 | Text1 | Текст4 | Text4

Текст3 | Text3 | Текст5 | Text5

# Написание Sql запросов.

Decision:

tbase2=# select words, dictionary.translate, description, Terms.translate

from dictionary

inner join Terms

on dictionary.id = Terms.words_id;

words | translate | description | translate

--------+-----------+-------------+-----------

Текст1 | Text1 | Текст4 | Text4

Текст3 | Text3 | Текст5 | Text5

(2 rows)

Source:

# https://proglib.io/p/rukovodstvo-po-sql-dlya-nachinayushchih-chast-1-sozdanie-bazy-dannyh-tablic-i-ustanovka-svyazey-mezhdu-tablicami-2022-02-07 - Руководство по SQL для начинающих. Часть 1: создание базы данных, таблиц и установка связей между таблицами.

# https://sql-academy.org/ru/guide/inner-join - Внутреннее соединение INNER JOIN.

Task:

Миграция базы с одного сервера на другой.

# Администрирование базы данных.

Decision:

(tenv) root@kvmubuntu:~# pg_dump -Fc -v --username=tuser --dbname=tbase2 -f datapsql2.dump

root@aw:/# scp datapsql2.dump tuser@tipubuntu:/home/tuser/

(tenv) root@kvmubuntu:~# pg_restore -v --no-owner --port=5432 --username=tuser --dbname=tbase2 datapsql2.dump

Source:

# https://www.youtube.com/@shcoder001 - Переводчик бот в telegram на python за 5 минут aiogram.

Task:

Применение библиотеки psycopg2.

# Разработка Переводчик.

Decision:

(tenv) root@kvmubuntu:~# python3 pyPsql.py

('Внутреннее соединение', 'Inner join', 'Возвращаются только те строки, где ключевые значения совпадают в обеих таблицах', 'Only those rows are returned where the key values match in both tables')

('Полное соединение', 'Cross Join', 'Позволяет получить декартово произведение нескольких таблиц. особенно полезен, когда между таблицами нет определенной связи, и вам нужно создать полную комбинацию записей из каждой таблицы', '-')

('Декартово произведение', 'Cartesian product', 'Результат соединения строки из первой таблицы с каждой строкой из второй таблицы', '-')

(tenv) root@kvmubuntu:~# python3 pyPsql.py

('Внутреннее соединение', 'Inner join', 'Возвращаются только те строки, где ключевые значения совпадают в обеих таблицах', 'Only those rows are returned where the key values match in both tables')

('Полное соединение', 'Cross Join', 'Позволяет получить декартово произведение нескольких таблиц. особенно полезен, когда между таблицами нет определенной связи, и вам нужно создать полную комбинацию записей из каждой таблицы', '-')

('Декартово произведение', 'Cartesian product', 'Результат соединения строки из первой таблицы с каждой строкой из второй таблицы', '-')

Source:

# https://ru.hexlet.io/blog/posts/python-postgresql - Использование Psycopg2.

# https://khashtamov.com/ru/postgresql-python-psycopg2/ - Начало работы.

Task:

Применение библиотеки Telebot.

# Разработка Переводчик.

Decision:

(tenv) root@kvmubuntu:~# python3 pyTranslatorMenuTelebot.py

- /Start

- Привет, David! Я тестовый бот.

Выбери программу, которую ты хочешь выполнить:

1. Чем полезен данный бот

2. Функции бота (что может данный бот)

3. Для тех кто хочет поддержать нас и наш проект

- Функции бота

- Добро пожаловать главное меню бота

В скором будущем мы будем добавлять сюда новые функции!

1. Переводчик

2. Словарь

- Переводчик

- Напишите сообщения, а я переведу его

- Привет, Катя!

- Hello, Katya!

- Переводчик

- Напишите сообщения, а я переведу его

- Dear Kate!

- Дорогая Кейт!

Source:

# https://www.w3schools.com/python/ref_func_input.asp - Python input() Function.

# https://proglib.io/p/samouchitel-po-python-dlya-nachinayushchih-chast-10-uslovnyy-cikl-while-2022-12-22 - Управление бесконечным циклом while в Питоне.

# https://letpy.com/python-guide/functions/ - Функции в Python для начинающих.

# https://ru.stackoverflow.com/questions/1211592/%D0%9A%D0%B0%D0%BA-%D1%81%D0%BE%D0%B7%D0%B4%D0%B0%D1%82%D1%8C-%D0%BC%D0%B5%D0%BD%D1%8E-%D1%81-%D0%B2%D1%8B%D0%B1%D0%BE%D1%80%D0%BE%D0%BC-%D1%84%D1%83%D0%BD%D0%BA%D1%86%D0%B8%D0%B9-%D0%BD%D0%B0-python - Как создать меню с выбором функций на Python?

# https://ru.stackoverflow.com/questions/1341916/%D0%9A%D0%B0%D0%BA-%D0%B7%D0%B0%D1%86%D0%B8%D0%BA%D0%BB%D0%B8%D1%82%D1%8C-%D0%BC%D0%B5%D0%BD%D1%8E-%D0%B8%D0%BC%D0%B5%D1%8E%D1%89%D0%B5%D0%B5-%D0%BF%D0%BE%D0%B4%D0%BC%D0%B5%D0%BD%D1%8E-%D0%B2-python - Как зациклить меню, имеющее подменю в python?

# https://docs.python.org/3/tutorial/venv.html - Creating Virtual Environments.

# https://www.youtube.com/watch?v=A1p7bEtTlxc&t=4s - Как сделать меню для Телеграм Бота на Python.

Task:

Добавить информацию в базу данных в телеграм бот.

# Разработка Переводчик.

Decision:

(tenv) root@kvmubuntu:~# psql -U tuser -d tbase2 -h tipubuntu

tbase2=# select * from Dictionary;

id | words | translate

----+------------------------+-------------------

1 | Внутреннее соединение | Inner join

2 | Доступ | Available

3 | Полное соединение | Cross Join

4 | Декартово произведение | Cartesian product

5 | Текст4 | Text4

(5 rows)

(tenv) root@kvmubuntu:~# vim .env

(tenv) root@kvmubuntu:~# cat .env

TOKEN='tkey'

DB_URL='postgres://tuser:tpassword@tipubuntu:5432/tbase2'

Decision:

(tenv) root@kvmubuntu:~# python3 py.py

- Чем полезен бот ?

- Функции бота:

1. Переводчик

2. Дополнить словарь

- Дополнить словарь

- Напишите 2 сообщения (предложение и его перевод), которые нужно добавить в словарь:

- new

новый

- Info added to the dictionary.

- Словарь

- Вывожу словарь:

| Inner join | Возвращаются только те строки, где ключевые значения совпадают в обеих таблицах | Only those rows are returned where the key values match in both tables |

| Cross Join | Позволяет получить декартово произведение нескольких таблиц. особенно полезен, когда между таблицами нет определенной связи, и вам нужно создать полную комбинацию записей из каждой таблицы | - |

| Cartesian product | Результат соединения строки из первой таблицы с каждой строкой из второй таблицы | - |

Selected to the dictionary.

(tenv) root@kvmubuntu:~# psql -U tuser -d tbase2 -h tipubuntu

tbase2=# select * from Dictionary;

...

49 | new | новый

tbase2=# TRUNCATE Terms, Dictionary CASCADE;

Source:

# https://stackoverflow.com/questions/75900203/how-do-i-connect-my-telegram-bot-telebot-to-postgresql-url - How do I connect my telegram bot (telebot) to PostgreSQL url.

# https://pythonru.com/osnovy/globalnye-peremennye-python - Правила использования global.

# https://ru.stackoverflow.com/questions/1103332/Авторизация-в-телеграмм-боте-на-python - Авторизация в телеграмм боте на Python.

# https://otvet.mail.ru/question/219454196 - Python. Telegram bot api Как из Username получить user_id.

# https://stackoverflow.com/questions/13223820/postgresql-delete-all-content - PostgreSQL удаляет все содержимое.

Task:

Настройка службы бота.

# Администрирование локальных серверов.

Decision:

root@kvmubuntu:~# vim /etc/systemd/system/dato38itbot.service

root@kvmubuntu:~# cat /etc/systemd/system/dato38itbot.service

[Unit]

Description=Telegram dato38it-bot

After=network.target

[Service]

User=tuser

Group=tuser

WorkingDirectory=/home/tuser/dato38itbot/

VIRTUAL_ENV=/home/tuser/dato38itbot/telegaenv

Environment=PATH=$VIRTUAL_ENV/bin:$PATH

ExecStart=/home/tuser/dato38itbot/telegaenv/bin/python /home/tuser/dato38itbot/main.py

Restart=on-failure

[Install]

WantedBy=multi-user.target

root@kvmubuntu:~# systemctl daemon-reload

root@kvmubuntu:~# systemctl enable dato38itbot.service

root@kvmubuntu:~# systemctl start dato38itbot.service

root@kvmubuntu:~# systemctl status dato38itbot.service

Source:

# https://thecode.media/systemctl/ - Готовим файл для работы службы.

# https://synay.net/vps/preconfigured/own-telegram-bot-server-debian-12 - Создадим файл службы, чтобы запускать бот автоматически.

# https://gist.github.com/ricferr/90583f608f0b0ae9c3cf6833be04ab85 - How to create a systemd service for python script with virtualenv.

2018-03-01 - 2022-11-01: Всероссийский государственный университет юстиции, Иркутск. Должность: Технический специалист. Достижения: Разработал программу Обработка и сортировка Html-кода с целью упрощения корректировки тегов на сайте организации по запросам от руководства Дополнительная информация: работа с сайтами, поддержка функционирования серверов и сервисов СУБД, техническая поддержка пользователей

Show more

Services:

# Разработка Парсинг данных в файлах.

# Разработка скрипта Парсинг документов на сайте.

Task:

В файле input.txt надо обычный текст преобразовать в html код формат, добавив только необходимые тэги, и записать результат в output.html.

# Разработка Парсинг данных в файлах.

Decision:

INFORMATION WILL BE ADDED SOON!

Source:

# https://pythonworld.ru/tipy-dannyx-v-python/fajly-rabota-s-fajlami.html - Чтение из файла.

# https://docs-python.ru/tutorial/chtenie-zapis-fajl/odnovremennoe-chtenie-zapis-raznye-fajly/ - Работа с несколькими файлами в Python.

# https://sky.pro/media/chtenie-fajla-postrochno-v-spisok-na-python/ - Использование встроенной функции open().

# https://sky.pro/media/chtenie-fajla-postrochno-v-spisok-na-python/?ysclid=lv9i6ky8w2363195830 - Использование генераторов.

# https://translated.turbopages.org/proxy_u/en-ru.ru.8446d21d-66250fbc-1552d51e-74722d776562/https/stackoverflow.com/questions/54785152/replace-tab-with-space-in-entire-text-file-python?__ya_mt_enable_static_translations=1 - Заменить табуляцию пробелом во всем текстовом файле python.

# https://pythonturbo.ru/kak-v-python-dobavit-tekst-v-fajl/ - Добавление текста в файл с помощью оператора with

Task:

На странице https://tdomain.ru/sveden/education под поле "Образовательная программа, направленность, профиль, шифр и наименование научной специальности" в таблице "Образование" (информация по образовательным программам) необходимо добавить тег itemprop="eduProf". В данной таблице тег <tr itemprop="eduOp">, который нужно заменить на <tr itemprop="eduOprog">.

# Разработка скрипта Парсинг сайта.

Decision:

INFORMATION WILL BE ADDED SOON!

ШАГИ ВЫПОЛНЕНИЯ:

1. Прорамма будет апрашивать страницу для парсинга.

2. Парсинг страницы сайта по тегам

3. Поиск тега который нужно аменить

4. амена тега

5. Публикация именения на сайт

Task:

Написать скрипт, который проверяет все страницы сайта на отсутствие pdf файлов больше 15 Мб.

# Разработка скрипта Парсинг документов на сайте.

Decision:

root@kvmubuntu:~# wget --no-check-certificate -r -l 1 -A pdf https://tdomain.ru/sveden/document

root@kvmubuntu:~# chmod +x FileWeight.sh

root@kvmubuntu:~# ./FileWeight.sh

Enter a link to the site: https://tdomain.ru/sveden/document

Come up with a name for the directory where the files will be written: tdir

/home/tuser/tdir create

...

root@kvmubuntu:~# cat /home/tuser/tdir/output

/home/tuser/tdir/tdomain.ru/Media/irk/Документы института/2018/tDoc1.pdf

root@kvmubuntu:~# ls -l /home/tuser/tdir/tdomain.ru/Media/irk/Документы\ института/2018/tDoc1.pdf

-rw-r--r--. 1 tuser tuser 20055320 июн 30 2018 '/home/tuser/tdir/tdomain.ru/Media/irk/Документы института/2018/tDoc1.pdf'

Source: